Je ziet het weleens in films: het hoofdpersonage denkt dat ze iemand op de weg zien lopen, dus ze zwenken opzij met de auto en eindigen in de greppel. Stelt u zich nu eens voor dat dit echt is — een soort van — en dat dit in plaats van door een illusie van het licht of ons brein door een cybercrimineel komt die een fractie van een seconde iets projecteert waarop de automatische piloot moet reageren omdat die zo geprogrammeerd is. Onderzoekers van Georgia Tech en de Ben-Gurion Universiteit van de Negev demonstreerden de risico’s van zo’n soort “spookaanval” tijdens de RSA Conference 2021.

Het idee van het tonen van gevaarlijke afbeeldingen aan AI-systemen is niet nieuw. Deze technieken maken vaak gebruik van gemodificeerde afbeeldingen om de AI te dwingen een onverwachte conclusie te trekken. Alle machine-learning-algoritmes hebben zo’n achilleshiel: het weten welke attributen essentieel zijn voor beeldherkenning — oftewel enige kennis van het algoritme — maakt het mogelijk om afbeeldingen te modificeren zodat ze het besluitvormingsproces van de machine kunnen belemmeren of het zelfs kunnen dwingen om een fout te maken.

De nieuwigheid van de aanpak die tijdens de RSA Conference 2021 werd gedemonstreerd is dat de automatische piloot niet-gemodificeerde afbeeldingen werd getoond — een aanvaller hoeft dan dus niet te weten hoe het algoritme werkt of van welke attributen het gebruikmaakt. De afbeeldingen werden kortstondig op de weg en nabije stationaire objecten geprojecteerd, met de volgende consequenties:

In een variatie op dit thema verschenen de afbeeldingen een fractie van een seconde in een commercial op een billboard aan de kant van de weg, met in feite hetzelfde resultaat:

De onderzoekers concludeerden daarom dat cybercriminelen flinke schade kunnen aanrichten vanaf een veilige afstand, zonder het risico te lopen om bewijs achter te laten op de plaats delict. Het enige dat ze hoeven te weten is hoelang ze de afbeelding moeten projecteren om de AI om de tuin te leiden (zelfrijdende auto’s hebben een hogere tijdsdrempel om de kans op foutpositieven te verkleinen, bijvoorbeeld door vuil op de cameralens of lidar.

De remafstand van een auto wordt in meters gemeten, dus het toevoegen van een paar decimeters voor betere beoordeling van situaties was geen probleem voor AI-ontwikkelaars.

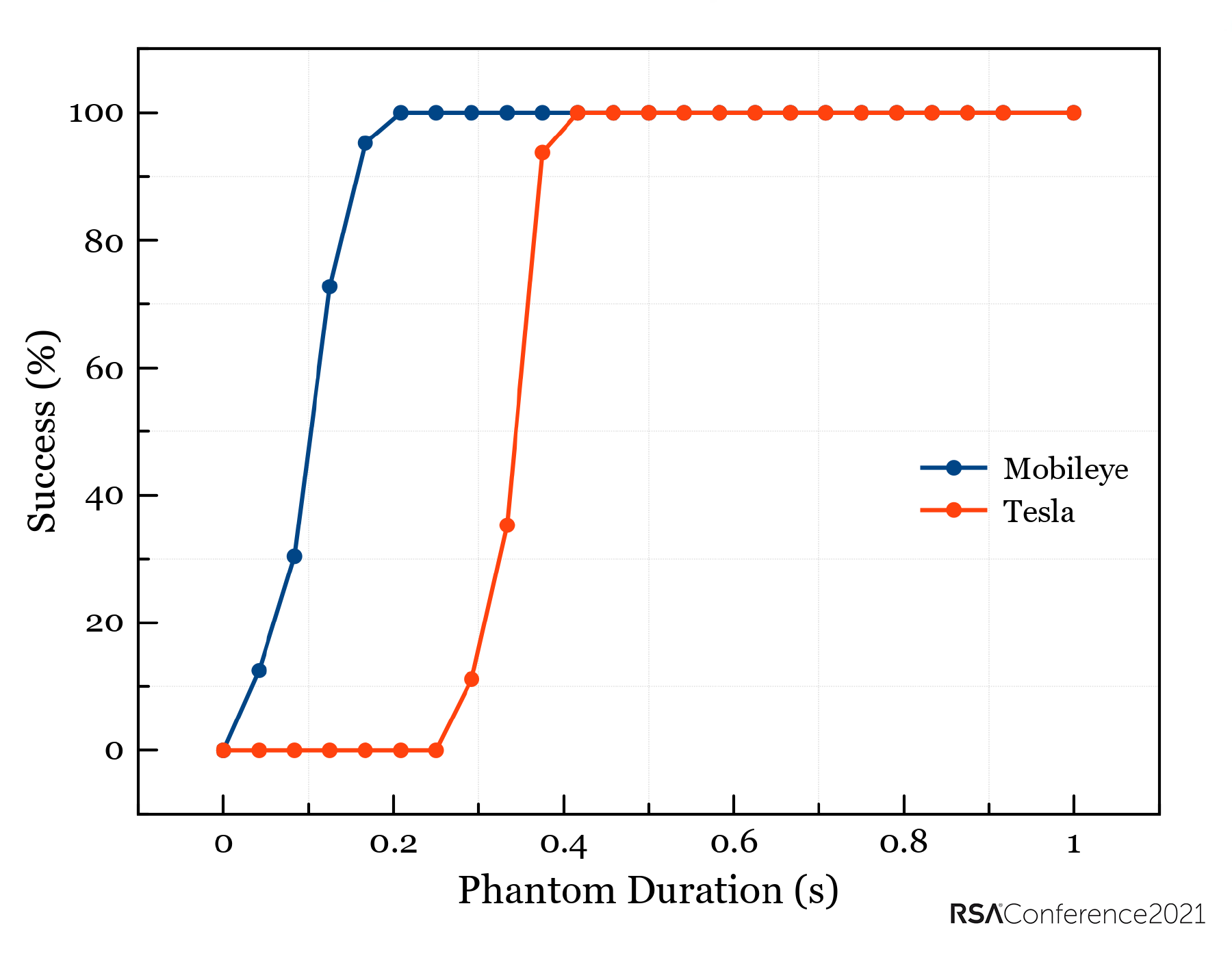

Vereiste tijdsduur voor de weergave van een spookafbeelding voor herkenningssystemen van Tesla en Mobileye. Bron

Maar het cijfer van een aantal meter is van toepassing op het kunstmatige visiesysteem van Mobileye en een snelheid van 60 km/u. In dat geval is de reactietijd ongeveer 125 milliseconden. De reactiedrempel van Tesla’s automatische piloot, zoals experimenteel vastgesteld door de onderzoekers, ligt bijna drie keer zo lang, op 400 milliseconden. Bij dezelfde snelheid zou dat bijna 7 meter meer zijn. Hoe dan ook: het is nog altijd een fractie van een seconde. De onderzoekers denken dan ook dat zo’n aanval uit het niets kan komen — voor u het weet ligt u in een greppel en is de beeld-projecterende drone verdwenen.

Een eigenaardigheid in het systeem wekt de hoop dat automatische piloten uiteindelijk in staat zullen zijn dit soort aanvallen af te slaan: beelden die worden geprojecteerd op oppervlakken die ongeschikt zijn om beelden op weer te geven, wijken sterk af van de werkelijkheid. Perspectiefvervorming, ongelijke randen, onnatuurlijke kleuren, extreem contrast en andere eigenaardigheden zorgen ervoor dat spookbeelden voor het menselijk oog zeer gemakkelijk van echte voorwerpen te onderscheiden zijn.

De kwetsbaarheid van de automatische piloot voor spookaanvallen is dan ook een gevolg van de perceptiekloof tussen AI en het menselijk brein. Om die kloof te overbruggen, stellen de onderzoekers voor om autopilot-systemen uit te rusten met extra controles op consistentie op het gebied van perspectief, gladheid van randen, kleur, contrast en helderheid, en om ervoor te zorgen dat de resultaten consistent zijn voordat er een beslissing wordt genomen. Net als bij een menselijk oordeel zullen neurale netwerken beraadslagen over de parameters die helpen om echte camera- of lidarsignalen te onderscheiden van een vluchtige spookafbeelding.

Dit zou uiteraard de rekenlast van de systemen verhogen en in feite leiden tot de parallelle werking van verschillende neurale netwerken tegelijk, die allemaal noodzakelijkerwijs moeten worden getraind (een langdurig en energie-intensief proces). En auto’s, nu al kleine clusters van computers op wielen, zullen moeten veranderen in kleine clusters van supercomputers op wielen.

Nu AI-versnellers populairder worden, kunnen auto’s wellicht meerdere neurale netwerken aan boord hebben die parallel werken en geen stroom verbruiken. Maar dat is een verhaal voor een andere keer.

RSAC

RSAC